(per Zufall wird ein Element ausgewählt, z.B. „super“)

Mensch: [„auch gut“ bestens]

(Mensch kann „auch gut“ oder „bestens“ sagen)

Pepper: ^rand[„das freut mich“ „alles klar“]

(per Zufall wird ein Element ausgewählt, z.B. „alles klar“)

usw.

Standardmäßig merkt sich Pepper nicht, worüber gesprochen wurde, d.h. er führt keine Dialogmodellierung durch. Diese sollte jedoch programmierbar sein, z.B. durch Verbindung mit zusätzlichen Chatbots, wie z.B. IBM Watson oder Microsoft Azure. Aufgrund der Erfordernis, alle Dialogoptionen vorzudefinieren, sind Gespräche mit Pepper zum aktuellen Zeitpunkt nicht sonderlich flexibel. Der menschliche Schreiber des Dialogs muss möglichst alle Benutzereingaben und sinnvolle Reaktionen bereits während des Entwicklungsprozesses vorhersehen und implementieren. Fehler im laufenden Dialog müssen durch selbstgeschriebene Mechanismen im Dialog behandelt werden.

Pepper besitzt die Fähigkeit, durch Interaktionen mit Menschen vier Basisemotionen in deren Gesichtern zu erkennen: Freude, Trauer, Ärger und Überraschung. Hierzu erkennt und integriert er visuelle, akustische und linguistische Merkmale, die er über seine eingebauten Kameras und Richtmikrofone von seinem menschlichen Gesprächspartner wahrnimmt. Dazu gehören unter anderem Mimik, Tonfall, verwendete Schlüsselwörter und die Haltung des Kopfes seines Interaktionspartners.

Pepper kann durch Kombination von verbalem und non-verbalem Verhalten positive und negative Emotionen wie Freude oder Langeweile darstellen. Als Mittel stehen ihm dafür die Anpassung verschiedener sprachlicher Parameter (Sprechgeschwindigkeit, Tonhöhe, Lautstärke, Pausen); paralinguistische Lautäußerungen; Gesten; Körperhaltung; Blickkontakt; sowie Variationen von Farbe und Leuchten („Blinken“ und „Rollen“) der LEDs seiner ‚Augen‘ zur Verfügung.12 Da Peppers Gesichtszüge starr sind, wie die einer Porzellanpuppe, spielt Mimik bei der Emotionsdarstellung keine Rolle.

Menschliche Gesichtszüge

In einigen Robotermodellen wird bereits mit beweglichen Gesichtszügen experimentiert. So hat sich die Firma Hanson Robotics auf humanoide Roboter mit menschenähnlichen Gesichtern und menschenähnlicher Mimik spezialisiert (siehe Sophia, Abb. I.11).

Auch Roboter wie Philip K. Dick (Hanson Robotics) oder die Geminoiden von Hiroshi Ishiguro haben menschenähnliche Gesichtszüge und Funktionen.

Zur Wahrnehmung seiner Umgebung ist Pepper mit einer Vielzahl von Sensoren ausgestattet. Dazu gehören zwei HD-Kameras (eine zwischen seinen ‚Augen‘ , eine in seinem ‚Mund‘ ), eine 3D-Kamera hinter den ‚Augen‘ und vier Richtmikrofone in seinem Kopf, mit denen er visuelle und akustische Informationen erfassen kann, unter anderem Sprache, menschliche Emotionsdarstellungen und Objekte in seiner Umgebung. Peppers Kopf und Hände sind mit taktilen Sensoren ausgestattet, die Berührung registrieren. Darüber hinaus verfügt Pepper in seinem Fuß über zwei Ultraschallsender und -empfänger (= Sonar), sechs Laser-Sensoren und drei Hindernisdetektoren. Damit kann er die Distanz zu Objekten in seiner Nähe bestimmen (Reichweite: 3 Meter). Weitere Sensoren messen innere Zustände des Roboters, wie z.B. die Temperatur seiner Komponenten oder den Batteriestand. Pepper ist bereits darauf programmiert, Sensordaten auf komplexe Art und Weise zu verarbeiten.

Wenn Pepper gerade mit nichts anderem beschäftigt ist, dann führt er autonom und zufallsgesteuert verschiedene körperliche Aktionen aus. Zum Beispiel öffnen und schließen sich dann seine Hände, er bewegt leicht die Arme, er imitiert durch leichte Oberkörperbewegungen eine Art Atmung, und er dreht den Kopf in verschiedene Richtungen. Diese Aktionen dienen vornehmlich einem Zweck, nämlich, dem Benutzer deutlich zu machen: „Ich lebe. Wäre ich eine Maschine, dann würde ich leblos auf meinem Platz warten, bis mich wieder jemand benutzt.“ Eine weitere Funktion ist vermutlich, Pepper beweglich zu halten.13

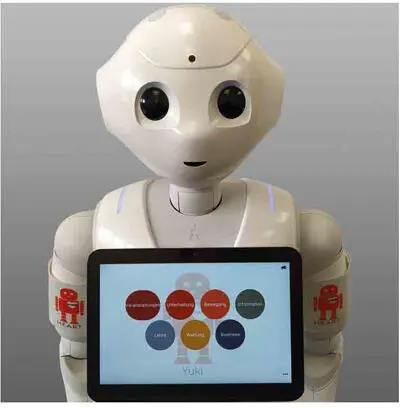

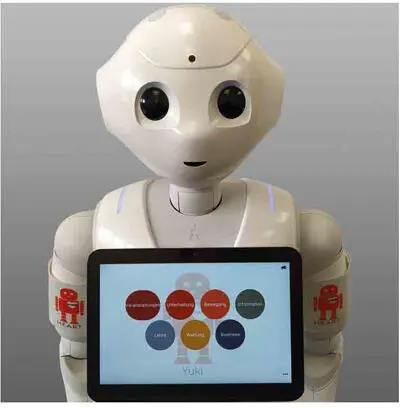

Peppers gesamtes Wesen und Verhalten sind darauf ausgelegt und ausgerichtet, dass er von Menschen ‚gemocht‘ wird. So beschreibt ihn der Hersteller als „freundlich, liebenswert und überraschend“. Seine Architektur ist für die Verrichtung körperlicher Arbeiten, insbesondere schwerer Arbeiten mit Lasten, ungeeignet. Sie ist dagegen prädestiniert für die Mensch-Maschine-Kommunikation und den Aufbau von Mensch-Maschine-Beziehungen. In den Bereichen Kommunikation und Beziehungsaufbau kann Pepper punkten mit natürlichsprachlicher Dialogfähigkeit, der Fähigkeit zur Erkennung und Darstellung von Emotionen sowie non-verbaler Kommunikation über Gestik, Blickkontakt und Körperhaltung. Außerdem ist er in der Lage, Menschen zu erkennen und wiederzuerkennen. Mit Hilfe des eingebauten Tablets lässt sich Pepper auch für Lehr- und Präsentationsaufgaben einsetzen.

Abb. I.22: Der H.E.A.R.T. App-Launcher

Pepper eignet sich also besonders gut für Rollen, in denen körperliche Aktionen (ausgenommen die non-verbale Kommunikation) die Ausnahme und Kommunikation und Beziehungsaufbau die Regel sind. Abb. I.22zeigt Pepper mit dem H.E.A.R.T. App-Launcher als Interface für den Start von Anwendungen in der digitalen Hochschullehre.

I.4 Ausblick und Lektüreempfehlungen

Die vorangegangenen Abschnitte haben das Thema humanoide Roboter von verschiedenen Perspektiven beleuchtet. Dabei wurde klar, dass die gegenwärtigen Fähigkeiten humanoider Roboter noch sehr überschaubar sind. Zwar gibt es bereits humanoide Roboter, die komplexe Interaktionen und Kommunikationsformen beherrschen, und sich damit als „soziale Roboter“ qualifizieren. Von den menschlichen Möglichkeiten des Informationsaustausches sind sie allerdings noch weit entfernt. Der niederländische Experte, Koen Hindriks, bringt es auf den Punkt:

Ein Roboter kann beobachten, Daten abrufen und etwas damit machen. Wenn ein Mensch etwas zu einer solchen Maschine sagt, passiert etwas. Aber die menschliche Kommunikation ist viel komplexer. So ist es noch sehr schwierig für einen Roboter, mit Gesten, Emotionen und anderen non-verbalen Kommunikationsformen umzugehen. Ein Roboter versteht beileibe nicht alles. Auch kann er im Unterschied zu uns Menschen nicht gleichzeitig sehen und hören. Und wenn sich Menschen aus seinem Blickfeld entfernen, spricht der Roboter einfach weiter. Also müssen wir den Robotern beibringen, sich an menschliches Verhalten anzupassen. Das alles steckt noch in den Kinderschuhen. (übertragen aus dem Niederländischen, INT10)

Auch der Robotiker Hendrik Schärfe aus Dänemark verschweigt keineswegs, dass sein Geminoid (siehe Abb. I.7) weit von tatsächlichen, fortgeschrittenen Fähigkeiten und Meilensteinen in der nützlichen Robotik entfernt ist. Die Fähigkeiten, die er mit seinem Geminoid-DK zur Schau stellt, kann genausogut jeder NAO-Roboter ausführen, da der Roboter ausschließlich das ausführt, was ihm vorher per Hand eingespeichert wurde. Vermutlich ist es aber auch gar nicht das Ziel des Projektes, Roboter an die menschliche Urteils- und Lernfähigkeit anzunähern. Geminoid-DK scheint eher ein Test zu sein, mit dem überprüft werden soll, wie täuschend ähnlich Roboter äußerlich und in gesteuerter Konversation ihrem menschlichen Pendant derzeit sein können.

Trotz ihrer derzeitigen Unzulänglichkeiten beginnen humanoide Roboter die Bereiche der menschlichen Gesellschaft, in die sie eingeführt werden, zu verändern. In dem Maße, wie ihre Zahl und die Vielfalt der Szenarien, in denen sie eingesetzt werden, zunehmen, werden die durch Roboter entstehenden Veränderungen von Menschen immer stärker wahrgenommen. Die Wertigkeit und Intensität dieser Wahrnehmung wird die Haltung von Menschen gegenüber humanoiden Robotern maßgeblich beeinflussen.

Читать дальше