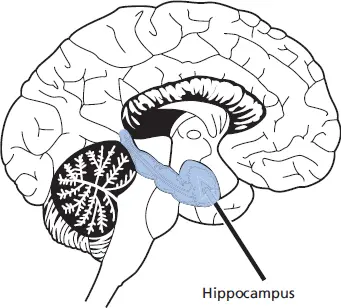

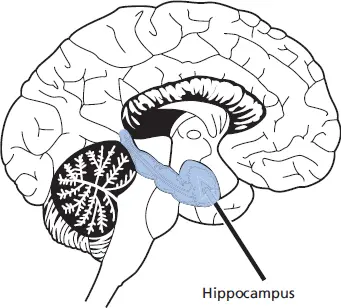

Abb. 1.1: Neuroanatomische Lokalisierung des Hippocampus

Fokus: Biologische Grundlagen des Lernens

Seit den Anfängen der Lernforschung hat man sich für die Frage interessiert, welche biochemischen Prozesse und neuroanatomischen Strukturen für Lernprozesse verantwortlich sind. Mit den biologischen Grundlagen menschlichen Lernens beschäftigen sich mit großem Erfolg die modernen Neurowissenschaften. Man weiß inzwischen, dass Strukturen des limbischen Systems, vor allem der Hippocampus, bei der Aufnahme, Verarbeitung und Konsolidierung von episodischen Informationen (Daten, Fakten, Namen) eine wichtige Rolle spielen, zusammen mit den kortikalen Strukturen des medialen Temporallappens. Beim willentlichen Abrufen episodischer Informationen aus dem Gedächtnis sind Aktivierungen im rechten dorsolateralen und medialen Frontalkortex zu beobachten. Beim Abrufen allgemeinen Weltwissens, das nicht mehr mit spezifischen Lernepisoden verknüpft ist, scheinen dagegen unterschiedliche kortikale Regionen im Temporallappenbereich beteiligt zu sein. Die Lokalisierung spezifischer Gedächtnisinhalte im Gehirn hat sich allerdings als äußerst schwierig erwiesen, da Gedächtnisinhalte nicht in einer Region, sondern weit verteilt über viele neuronale Systeme repräsentiert sind (Squire & Kandel, 1999).

Generalisierung und Diskrimination. Mike Rinck (2016) hat zu Recht darauf hingewiesen, dass die praktische Bedeutung des respondenten Konditionierens daher rührt, dass es nicht auf exakt die Reize beschränkt ist, mit denen konditioniert wird. Zu den konditionierten Reaktionen (CR) kommt es nach einer Phase hinreichender Kontingenz auch auf Reize, die dem ursprünglichen konditionierten Stimulus (CS) ähneln. Hier gilt das Prinzip der Stimulus-Generalisierung: Je ähnlicher ein Reiz dem ursprünglichen CS ist, desto eher und stärker wird auch er die CR auslösen können. Der Vollständigkeit halber weisen wir ausdrücklich darauf hin, dass die Reiz-Generalisierung auch Grenzen hat. Solche Grenzen rühren beispielsweise daher, dass Menschen (wie Tiere) grundsätzlich in der Lage sein müssen, überhaupt zwischen ähnlichen, aber nicht identischen Reizen unterscheiden zu können (Stimulus-Diskrimination).

1.2 Lernen als Verhaltensänderung

Durch gänzlich pragmatische Umsetzungen der assoziationstheoretischen Überlegungen Thorndikes begann in den 1920er Jahren eine neue, verhaltensorientierte (behavioristische) Auffassung des Lernens ihren weltweiten Siegeszug. Als Gründer dieser mit großem pädagogischen Optimismus betriebenen, jedoch dem Wesen nach eher atheoretischen Lernphilosophie gilt John B. Watson. Zu den Kernannahmen der behavioristischen Sichtweise zählen,

1. dass Lernen – wissenschaftlich verstanden – gleichzusetzen ist mit sichtbaren Verhaltensänderungen,

2. dass diese Verhaltensänderungen eine direkte, also nicht durch intrapsychische Zwischenprozesse vermittelte, Funktion der Verknüpfung von Umweltreizen (Stimuli) und Verhaltensweisen (Reaktionen) sind, und

3. dass der Aufbau von Verhaltensweisen in hohem Maße durch das Ausnutzen von Reiz-Reaktions-Kontingenzen beeinflussbar ist (Watson, 1919).

Schon früh wurde der behavioristische Verzicht auf Annahmen über die intrapsychischen Zwischenprozesse kritisiert. Dennoch dauerte es bis in die 1960er Jahre, bis sich Vorläufer der heute dominierenden Auffassungen von Lernen (  Kap. 1.3und

Kap. 1.3und  Kap. 1.4) durchsetzen konnten. Wesentlich für den lang anhaltenden Erfolg behavioristischer Lernauffassungen waren die vornehmlich tierexperimentellen Arbeiten von Burrhus F. Skinner, der mit großem Geschick pädagogisch leicht umsetzbare Lernprinzipien der Verhaltensformung herausgearbeitet hat. Skinners Werk gilt nicht zuletzt wegen seiner Klarheit und des unmissverständlichen Anspruchs, Lernen als objektiv-beschreibende Verhaltenswissenschaft zu betreiben, als radikal-behavioristisch.

Kap. 1.4) durchsetzen konnten. Wesentlich für den lang anhaltenden Erfolg behavioristischer Lernauffassungen waren die vornehmlich tierexperimentellen Arbeiten von Burrhus F. Skinner, der mit großem Geschick pädagogisch leicht umsetzbare Lernprinzipien der Verhaltensformung herausgearbeitet hat. Skinners Werk gilt nicht zuletzt wegen seiner Klarheit und des unmissverständlichen Anspruchs, Lernen als objektiv-beschreibende Verhaltenswissenschaft zu betreiben, als radikal-behavioristisch.

Verhaltensänderung durch Verstärkungskontingenzen (operantes Konditionieren)

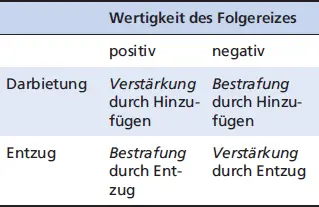

Die Annahme, dass Lernen durch Kontingenz entsteht, war bereits zentraler Bestandteil des im vorigen Abschnitt beschriebenen klassischen Konditionierens: Dort gilt die Kontingenz zwischen zwei Reizen (NS–US) als Bedingung der Assoziationsbildung, indem eine ursprünglich nur auf den unkonditionierten Stimulus (US) hin gezeigte unkonditionierte Reaktion (UR) am Ende eines erfolgreichen Lernvorgangs auch auf den zuvor neutralen (NS), jetzt neu assoziierten Stimulus erfolgte. Dieser Grundgedanke wird in Skinners (1953) Konzept des operanten Konditionierens von einer Kontingenz zwischen zwei Komponenten zu einer mit dreien erweitert. Durch die sogenannte Verstärkungskontingenz wird nämlich »gelernt«, dass eine Reaktion (R), die im Anschluss an eine bestimmte Reizsituation (S) gezeigt wird, eine angenehme (Verstärkung) oder unangenehme Empfindung (Bestrafung) zur Folge haben kann. Als prinzipielle Möglichkeiten der Verhaltensformung durch die Anwendung von Verstärkungskontingenzen hat Skinner (1953) vier operante Lernprinzipien beschrieben. Sie unterscheiden sich danach, ob das Wirkverhalten durch pädagogische Konsequenzen verstärkt oder bestraft wird, und ob dies durch Hinzufügen oder durch den Entzug eines Folgereizes geschieht.

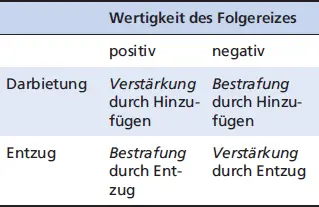

Fokus: Vier operante Lernprinzipien

Wertigkeit des Folgereizes

Kontingent applizierte positive und negative Verstärkungen (also das Hinzufügen eines angenehmen oder das Entfernen eines unangenehmen Folgereizes) führen zu einer Erhöhung der Auftretenswahrscheinlichkeit des zuvor gezeigten Verhaltens, während die beiden Formen der Bestrafung (also das Hinzufügen eines unangenehmen oder das Entfernen eines angenehmen Folgereizes) die Auftretenswahrscheinlichkeit des entsprechend kontingent betroffenen Verhaltens reduzieren.

Verstärkungspläne. Die naheliegende pädagogische Anwendung der operanten Lernprinzipien wären Maßnahmen der kontinuierlichen Verstärkung, bei denen systematisch jedes Auftreten einer erwünschten Verhaltensweise durch einen als angenehm empfundenen Folgereiz belohnt wird (positive Verstärkung). Ein klassisches Beispiel, das die Wirksamkeit einer so applizierten kontinuierlichen Verstärkung demonstriert, findet sich bei Etzel und Gewirtz (1967). Die Autoren wollten dem sechs Wochen alten William, der in einer Kindertagesstätte durch scheinbar grundlos häufiges und anhaltendes Schreien aufgefallen war, diese Verhaltensweise abgewöhnen. Zunächst wurde Williams Verhalten sorgfältig beobachtet. Dabei zeigte sich, dass er in einer festgelegten Zeiteinheit nur selten (elfmal) lächelte, aber überwiegend schrie. In einer daran anschließenden kontinuierlichen Verstärkungsphase wurde auf jedes Lächeln Williams’ sofort mit der freundlichen Redewendung »William ist ein guter Junge« und mit einem zwei Sekunden dauernden Zurücklächeln reagiert. Jedes Schreien Williams wurde in dieser Phase ignoriert. Nach Abschluss dieser kontinuierlichen Verstärkungsphase lächelte William viermal häufiger als zuvor und er schrie nicht mehr.

Solche Formen kontinuierlicher Verstärkung dürften sich im pädagogischen Alltag nur selten realisieren lassen. So kann z. B. eine (Tages-)Mutter, die sich gleichzeitig um mehrere Kinder kümmern muss, gar nicht jedes Lächeln eines häufig schreienden Kindes wahrnehmen und entsprechend durch Zuwendung verstärken. Realistischerweise wird sie also die erwünschten Verhaltensweisen auch nur eines einzelnen Kindes wahrscheinlich nur gelegentlich, d. h. partiell verstärken können, weil ihr vermutlich vieles entgeht. Selbst in den tierexperimentellen Laborversuchen Skinners kam es immer wieder zu partiellen bzw. intermittierenden anstelle von kontinuierlichen Verstärkungen, da es nicht immer gelang, jedes erwünschte Verhalten durch die stets gleiche Verstärkungsdosis (z. B. Anzahl der Futterpillen) zu belohnen. Überraschenderweise zeigte sich aber, dass es nach den gelegentlichen, intermittierenden Verstärkungen durchaus auch zum Aufbau des erwünschten Verhaltens kam, allerdings wurde dazu – was nicht weiter verwundert – mehr Zeit benötigt. Zwei interessante Beobachtungen sprechen dafür, dass die intermittierende Verstärkung der kontinuierlichen sogar vorzuziehen ist: Zwar dauert der Aufbau des erwünschten Verhaltens beim intermittierenden Verstärken länger, jedoch wird dieses Verhalten nach etwa der gleichen Anzahl von Verstärkergaben (Dosis) erreicht. Und es hat sich gezeigt, dass intermittierend verstärktes Verhalten im Vergleich zu kontinuierlich verstärktem löschungsresistenter ist, also nach Absetzen der Verstärker länger anhält und beibehalten wird (Robbins, 1971).

Читать дальше

Kap. 1.3und

Kap. 1.3und