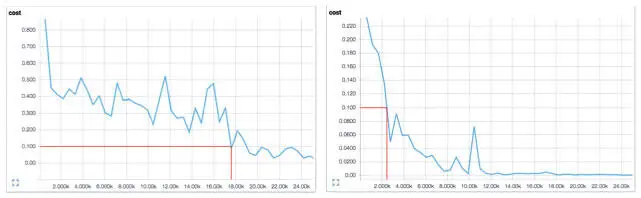

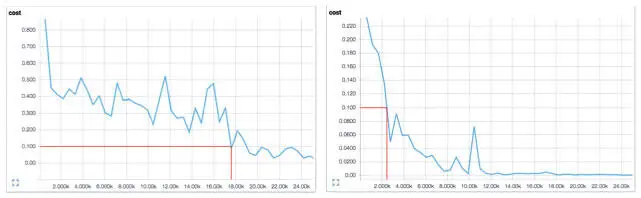

Ускорение вычислений поразительно. Изменение функции потерь со временем видно на примере сравнения визуализаций TensorBoard на рис. 4.9. Здесь показано, что для достижения потерь в 0,1 без импульса (слева) требуется почти 18 000 шагов (мини-пакетов), а с импульсом (справа) — чуть более 2000.

Рис. 4.9. Сравнение для сети с прямым распространением сигнала с импульсом (справа) и без импульса (слева) показывает значительное сокращение времени обучения

В последнее время появилось много исследований, направленных на улучшение классического импульсного метода. В работе Ильи Суцкевера и его коллег (2013) предложена альтернатива: импульсный метод Нестерова, который вычисляет градиент на поверхности ошибок во время обновления скорости при θ + v i − 1, а не θ [45]. Эта тонкая разница позволяет более эффективно изменять скорость. Было доказано, что этот метод имеет явные преимущества при пакетном градиентном спуске (гарантирует сходимость и может использовать большее значение импульса для заданного темпа обучения по сравнению с классическим). Но не до конца понятно, есть ли выгоды при стохастическом мини-пакетном градиентном спуске, который используется в большинстве подходов оптимизации для глубокого обучения. На момент написания этой книги импульсный метод Нестерова в TensorFlow не поддерживался [46].

Краткий обзор методов второго порядка

Как мы уже говорили в предыдущих разделах, вычисление гессиана — сложная задача, а импульс позволяет добиться значительного ускорения вычислений без его участия. Но за последние несколько лет разработано несколько методов второго порядка, которые направлены на аппроксимацию гессиана. Для более полной картины дадим краткий обзор этих методов, а их подробное описание выходит за рамки настоящей книги.

Один из них — метод сопряженных градиентов, который вырос из попыток улучшить наивный метод кратчайшего спуска. При кратчайшем спуске мы вычисляем направление градиента и проводим линейный поиск для нахождения минимума по нему. Мы переходим к минимуму и снова вычисляем градиент, чтобы определить направление следующего линейного поиска.

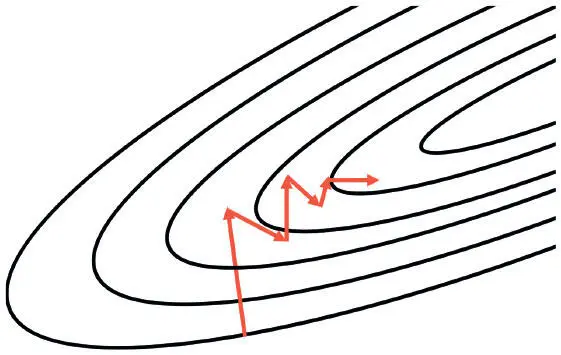

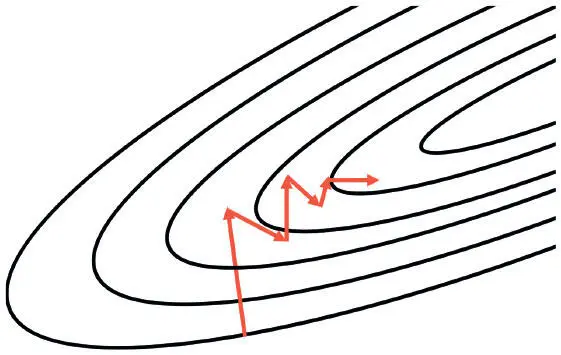

Этот метод приводит к разнообразным зигзагам (рис. 4.10), ведь каждый раз, когда мы движемся в сторону кратчайшего спуска, мы немного откатываемся в другом направлении. Решение — движение в сопряженном направлении относительно предыдущего, а не к кратчайшему спуску. Направление выбирается методом косвенного аппроксимирования гессиана для линейного сочетания градиента и предыдущего направления. При небольших модификациях метод обобщается до невыпуклых поверхностей ошибок, характерных для глубоких сетей [47].

Рис. 4.10. Метод кратчайшего спуска часто дает зигзаги; сопряженный спуск направлен на решение этой проблемы

Альтернативный алгоритм оптимизации называется алгоритмом Бройдена — Флетчера — Гольдфарба — Шанно (BFGS) [48]и заключается в итеративном вычислении обратной матрицы Гессе для более эффективной оптимизации вектора параметров. Изначально BFGS предъявлял значительные требования к памяти, но уже разработана более эффективная версия — L-BFGS [49].

Эти подходы перспективны, но методы второго порядка по-прежнему остаются областью активных исследований и у практиков непопулярны. TensorFlow на момент написания этой книги не поддерживал ни метода сопряженных градиентов, ни L-BFGS.

Еще одна серьезная проблема при обучении глубоких сетей — выбор правильного темпа. Эта задача уже давно считается одним из самых проблематичных аспектов обучения глубоких сетей, поскольку темп серьезно влияет на эффективность. Слишком низкий не позволит обучаться быстро, а слишком высокий может привести к проблемам со сходимостью при достижении локального минимума или плохо обусловленного участка.

Один из главных новых прорывов в области оптимизации глубоких сетей — возможность адаптации темпа обучения. Смысл в том, что темп модифицируется в процессе для достижения хорошей сходимости. В следующих разделах мы рассмотрим три самых популярных алгоритма адаптации темпа обучения: AdaGrad, RMSProp и Adam.

Читать дальше

Конец ознакомительного отрывка

Купить книгу