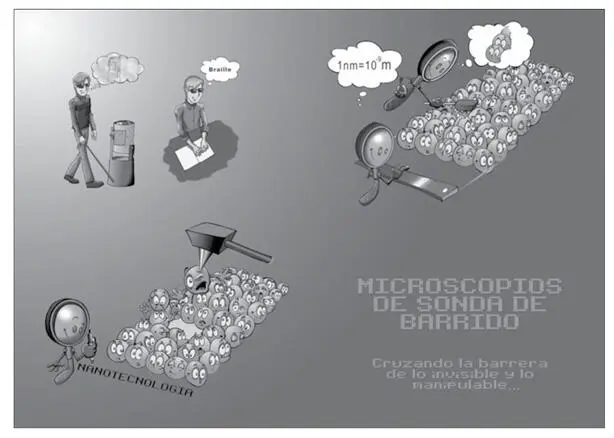

Un año crucial en la carrera hacia el nanomundo fue 1981. Ese año, en el laboratorio ibm de Zurich, Gerd Binning y Hein-rich Roher construyeron un nuevo tipo de microscopio, denominado microscopio de efecto túnel. Cinco años más tarde, en 1986, recibían el Premio Nobel. Asimismo en 1986, el propio Binning, junto con Christopher Gerber y Calvin Quate, construía el primer prototipo de microscopio de fuerzas atómicas. Ambos tipos de microscopio se conocen como microscopios de sonda de barrido.

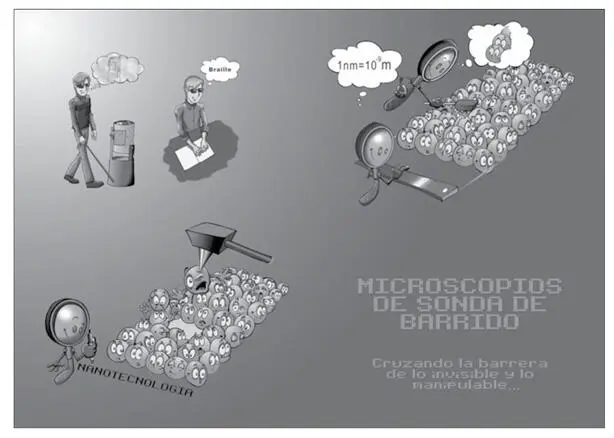

El fundamento de estos microscopios es diferente a los descritos anteriormente o a la propia difracción de rayos X. Guardan similitudes con el método Braille de lectura de los ciegos, un método de lectura táctil basado en la sustitución de las letras por puntos en relieve, igualmente invisibles a sus ojos, pero sensibles a las yemas de los dedos. La esencia de los microscopios de sonda de barrido es una punta extremadamente fina, que permite «ver» e incluso «tocar» los átomos confinados en una superficie. Al barrer la superficie, esa punta se comporta como una sonda o sensor, capaz de «palpar» los átomos e informarnos de su distribución sobre la superficie (véase fig. 2). Evidentemente, para poder «palpar los átomos» y evitar el problema de los «dedos gordos», la punta debe ser lo suficientemente fina. En realidad, la punta está formada por sólo unos pocos átomos.

Así pues, estos microscopios de sonda de barrido, más que detectar las ondas dispersadas por el objeto que queremos visualizar, sienten la superficie de la muestra con una extrema sensibilidad. Son los nuevos ojos del nanocosmos, que nos permiten ver atómos individuales en diferentes entornos. Pero más allá de la simple visualización, ¡estos instrumentos nos abren las puertas a la manipulación de la materia a escala atómica!

Figura 2. Microscopios de sonda de barrido: cruzando la barrera de lo invisible y lo manipulable.

ARQUITECTURA EN LA NANOESCALA: CRUZANDO LA BARRERA DE LO MANIPULABLE

Le propongo ahora un sencillo experimento. Coja un papel y pártalo en trozos pequeños. Coja un lápiz y frote la punta. Acerque entonces la punta del lápiz a los papelitos. ¿Qué ha sucedido? ¡Sorpresa! La punta del lápiz actúa como una pin-zas, capaz de sujetar a los trozos de papel. Y quizás se pregunte qué tiene que ver este experimento con la nanotecnología. Pues bien, si a la punta de ese microscopio de sonda de barrido, capaz de «palpar» los átomos (método de visualización), se le aplica una corriente eléctrica o potencial, la punta se comporta como una pinza, capaz de coger a los átomos y moverlos a voluntad (método de manipulación).

Y eso fue lo que hizo Don Eigler. Con un microscopio de efecto túnel, en 1985 escribió la palabra ibm –logo de su compañía– moviendo 35 átomos de xenón sobre una superficie de níquel. Fue una imagen que dio la vuelta al mundo. Por primera vez el hombre lograba manipular la materia a escala atómica. Se confirmaban así las predicciones del genial Richard Feynman: «Los principios de la física, tal y como yo lo veo, no impiden la posibilidad de manipular las cosas átomo a átomo». En todo caso, resulta inviable generar unos pocos gramos de material, átomo a átomo, siguiendo este procedimiento. Nos llevaría un tiempo infinito. Así pues, necesitamos otros métodos de manufactura molecular.

La biología nos muestra eficientes técnicas de fabricación en la nanoescala. Rousseau decía: «Hay un libro abierto siempre a todos los ojos, la naturaleza». Y George Whitesides, de la Universidad de Harvard, ha sabido leer e interpretar magistralmente ese libro. A él le debemos eficientes estrategias, como el denominado autoensamblado molecular.

En un proceso de autoensamblaje, átomos, moléculas, agregados de moléculas y componentes se organizan por sí mismos en entidades ordenadas y funcionales, sin implicación humana. Lo único que tenemos que hacer es crear las condiciones adecuadas (temperatura, presión, etc.), colocar juntas a las moléculas adecuadas y dejarlas trabajar, que ellas mismas construyan la estructura. El autoensamblado necesita personas que diseñen el proceso y personas que lo pongan en marcha. Pero una vez iniciado el proceso, éste seguirá espontáneamente. ¡Los materiales del futuro se construirán a sí mismos!

Por otra parte, cabe destacar que el autoensamblado molecular se trata de un proceso en paralelo y no en serie, como el que haría un brazo robótico o la punta de un microscopio de sonda de barrido. Billones de moléculas se posicionarán si-multáneamente en alguno de los lugares permitidos. Los tiempos de fabricación se reducen enormemente. Ahí radica otra de sus grandes ventajas.

Esta técnica de fabricación es una aproximación bottom-up (de abajo-arriba): a partir de los bloques básicos, átomo a átomo, se construye el material. Es algo similar a un albañil, que a partir de los ladrillos construye el edificio, como ya hemos mencionado. Otra aproximación diferente es la top-down (de arriba-abajo). En este caso, el análogo sería el artista que con el cincel va tallando la escultura. El mundo de la informática ha sido testigo de esta aproximación. La luz hace el papel de cincel, reemplazando la oblea de silicio al mármol. Desde los inicios de esta técnica, conocida como litografía, las obleas de silicio se han ido tallando con cinceles cada vez más pequeños, para así incorporar más transistores en el mismo chip. Lo analizaremos más a fondo en posteriores capítulos.

Hay otro tipo de litografía, denominada litografía blanda, desarollada esencialmente por George Whitesides. En cierto modo, se asemeja a la fotografía. Primero se obtiene el equivalente a un negativo fotográfico, que actúa de máscara o patrón. Se trata de un solo evento, quizás lento y costoso. Pero una vez generado el patrón, podemos general multitud de copias de la nanoestructura requerida de forma sencilla, rápida y económica. Como máscara o molde, Whitesides utiliza PDMS (polidimetiloxano), el polímero gomoso que sirve para tapar grietas en las bañeras. Los físicos suelen llamar materias blandas a estos compuestos orgánicos, de ahí la denominación de litografía blanda.

LAS CONSECUENCIAS DE PENSAR EN PEQUEÑO

El primer ordenador programable, el ENIAC (Electronic Numerical Integrator and Computer) se construyó en 1944. Basado en los denominados tubos de vacío, pesaba 30 toneladas y ocupaba 160 metros cúbicos. Tardaba 30 segundos en efectuar un simple cálculo, como el de la trayectoria de un proyectil. Pero lo que resulta más llamativo es que consumía más energía en calcular la trayectoria del proyectil que en dispararlo. En 1949 un grupo de expertos predijo que algún día un ordenador tan potente como el ENIAC podría ser tan ligero y consumir tan poca energía como un automóvil. En realidad, muchos de nuestros gadgets tecnológicos actuales, como un teléfono móvil, son miles de veces más potentes que el ENIAC y consumen menos energía que uno de sus 18 tubos de vacío.

Quizás la informática sea el sector en el que mejor se puede apreciar esa tendencia a la miniaturización. Pero más pequeño no sólo significa más práctico y móvil, sino también más rápido. El corazón del ordenador está formado por un montón de transistores, dispositivos que regulan el paso de corriente, permitiendo o impidiendo el flujo de electrones. Pues bien, más pequeño se traduce en menos recorrido para los electrones y, por lo tanto, mayor rapidez y menor gasto energético. Más pequeño también se traduce en menor consumo de material.

¿Cuándo podemos situar los comienzos de la miniaturización? Los científicos griegos construyeron magníficos relojes astronómicos utilizando pequeñas ruedas dentadas. No eran sino representaciones en miniatura del sistema solar. Los sucesivos avances en la relojería desempeñaron un papel esencial en la miniaturización de los mecanismos y dispositivos utilizados en autómatas y robots. Al igual que sucede con la carrera espacial, la carrera hacia lo más pequeño ha actuado como fuerza motriz para los avances de la ciencia y la tecnología, proporcionando otros desarrollos colaterales.

Читать дальше