Douglas C. Montgomery - Introduction to Linear Regression Analysis

Здесь есть возможность читать онлайн «Douglas C. Montgomery - Introduction to Linear Regression Analysis» — ознакомительный отрывок электронной книги совершенно бесплатно, а после прочтения отрывка купить полную версию. В некоторых случаях можно слушать аудио, скачать через торрент в формате fb2 и присутствует краткое содержание. Жанр: unrecognised, на английском языке. Описание произведения, (предисловие) а так же отзывы посетителей доступны на портале библиотеки ЛибКат.

- Название:Introduction to Linear Regression Analysis

- Автор:

- Жанр:

- Год:неизвестен

- ISBN:нет данных

- Рейтинг книги:4 / 5. Голосов: 1

-

Избранное:Добавить в избранное

- Отзывы:

-

Ваша оценка:

Introduction to Linear Regression Analysis: краткое содержание, описание и аннотация

Предлагаем к чтению аннотацию, описание, краткое содержание или предисловие (зависит от того, что написал сам автор книги «Introduction to Linear Regression Analysis»). Если вы не нашли необходимую информацию о книге — напишите в комментариях, мы постараемся отыскать её.

New exercises and data sets New material on generalized regression techniques The inclusion of JMP software in key areas Carefully condensing the text where possible

skillfully blends theory and application in both the conventional and less common uses of regression analysis in today's cutting-edge scientific research. The text equips readers to understand the basic principles needed to apply regression model-building techniques in various fields of study, including engineering, management, and the health sciences.

and

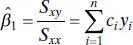

and  have several important properties. First, note from Eqs. (2.6)and (2.7)that

have several important properties. First, note from Eqs. (2.6)and (2.7)that  and

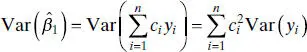

and  are linear combinationsof the observations yi . For example,

are linear combinationsof the observations yi . For example,

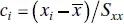

for i = 1, 2, …, n .

for i = 1, 2, …, n . and

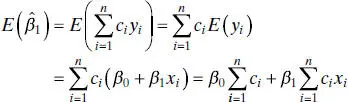

and  are unbiased estimatorsof the model parameters β 0and β 1. To show this for

are unbiased estimatorsof the model parameters β 0and β 1. To show this for  , consider

, consider

and

and  , so

, so

is an unbiased estimator of β 1. Similarly we may show that of

is an unbiased estimator of β 1. Similarly we may show that of  is an unbiased estimator of β 0, or

is an unbiased estimator of β 0, or

is found as

is found as

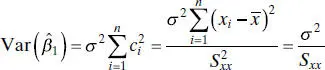

, and we have assumed that Var( yi ) = σ 2; consequently,

, and we have assumed that Var( yi ) = σ 2; consequently,

is

is

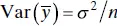

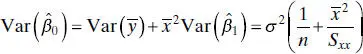

is just

is just  , and the covariance between

, and the covariance between  and

and  can be shown to be zero (see Problem 2.25). Thus,

can be shown to be zero (see Problem 2.25). Thus,

and

and  is the Gauss-Markov theorem, which states that for the regression model (2.1)with the assumptions E ( ε ) = 0, Var( ε ) = σ 2, and uncorrelated errors, the least-squares estimators are unbiased and have minimum variance when compared with all other unbiased estimators that are linear combinations of the yi . We often say that the least-squares estimators are best linear unbiased estimators, where “best” implies minimum variance. Appendix C.4proves the Gauss-Markov theorem for the more general multiple linear regression situation, of which simple linear regression is a special case.

is the Gauss-Markov theorem, which states that for the regression model (2.1)with the assumptions E ( ε ) = 0, Var( ε ) = σ 2, and uncorrelated errors, the least-squares estimators are unbiased and have minimum variance when compared with all other unbiased estimators that are linear combinations of the yi . We often say that the least-squares estimators are best linear unbiased estimators, where “best” implies minimum variance. Appendix C.4proves the Gauss-Markov theorem for the more general multiple linear regression situation, of which simple linear regression is a special case.