3 Mentale Prozesse bei der Rezeption und Verarbeitung audiovisueller Daten

Das Medium Film hat in der Vergangenheit nur zögerlich Einzug in das fremdsprachliche Klassenzimmer gehalten. Gründe für dieses eher marginale Dasein liegen nicht zuletzt in den damit verbundenen Schwierigkeiten und Herausforderungen, die es zu überwinden und zu meistern gilt. Die anfängliche Zurückhaltung geht oft mit der Befürchtung einher, dass viele Personen mit der Bilderflut der Massenmedien kognitiv überfordert sind und in der Masse der Informationen ertrinken. Dabei ist nicht die Menge an Informationen das Problem, „sondern der effektive Umgang damit“ (Ballsteadt 2004, 12).

Bei der Rezeption audiovisueller Daten im Klassenzimmer wird der Lernende sowohl mit visuellen als auch mit verbalen Informationen konfrontiert. Unabhängig davon, wie gut das zu Grunde liegende audiovisuelle Medium ist, so ist sein Einsatz erst dann effektiv, wenn „[…] sich der Lehrer über sein Ziel, d.h. über kognitive, affektive und psychomotorische Lernziele […]“ bewusst ist (Spreitzer 1977, 117). Folglich fordert die audiovisuelle Rezeptionsdidaktik nicht nur Kenntnisse über medienimmanente Zusammenhänge (cf. Schludermann 1981, 117), sondern ebenso über die Rezeption und Verarbeitung audiovisueller Daten. Das Wissen des Lehrers über diesbezügliche mentale Prozesse stellt daher eine wichtige Grundlage für die systematische Erarbeitung von Übungsformen dar, um Schüler in ihrem Hör-Seh-Verstehen zu schulen. In diesem Sinne zielt das vorliegende Kapitel darauf ab, einen Einblick in lernpsychologische Aspekte zu ermöglichen und auf dieser Basis adäquate Übungsstrategien hinsichtlich audiovisueller Datenverarbeitung vorzustellen.

3.1 Audiovisuelle Informationsverarbeitung

Bei der Ausstrahlung audiovisueller Dokumente findet eine Informationsübertragung mittels verschiedener Sinneskanäle statt: dem visuellen und dem akustischen. Anders als bei realen Kommunikationssituationen können Sender und Empfänger audiovisueller Inhalte einander in ihren Aussagen und ihrem Sprechtempo nicht beeinflussen. Ein Eingriff in die präsentierten Inhalte ist nicht möglich, weswegen die Informationsaufnahme einseitig durch den Rezipienten stattfindet. Da es sich um eine sogenannte Einwegkommunikation handelt, besteht die Aufgabe und Leistung des Hör-Sehenden zum Zeitpunkt der audiovisuellen Rezeption darin,

informative Signale, die ihm über mehrere Sinneskanäle zugeführt werden, und die zudem ganz unterschiedlichen semiotischen Systemen angehören, auf[zu]nehmen und zu sinnvollen Bewusstseinsinhalten [zu] verschmelzen (Scherer 1984, 20).

Man spricht hierbei allgemein auch von multimodaler Sprachverarbeitung, da der mentale Apparat aus verschiedenen sensorischen Modulen besteht: dem visuellen, auditiven, gustatorischen, taktilen und olfaktorischen Modul (cf. Ballstaedt 1988, 7). Die erfolgreiche Verarbeitung der wahrgenommenen Stimuli ist abhängig von dem Zusammenspiel verschiedener psychologischer, physiologischer und physikalischer Faktoren, die in gegenseitiger Wechselwirkung zueinander stehen und zu einer einheitlichen Wahrnehmung beitragen. Die zu Grunde liegenden Verarbeitungsprozesse sind allerdings derart komplex, dass insbesondere die Frage nach dem Integrationsmechanismus „auditiver und visueller sprachlicher Information […] bisher noch nicht ausreichend geklärt“ ist (Schmid 2007, 24).

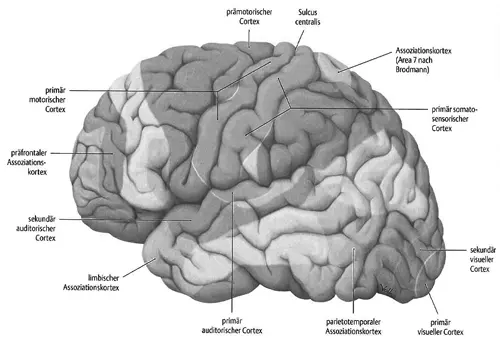

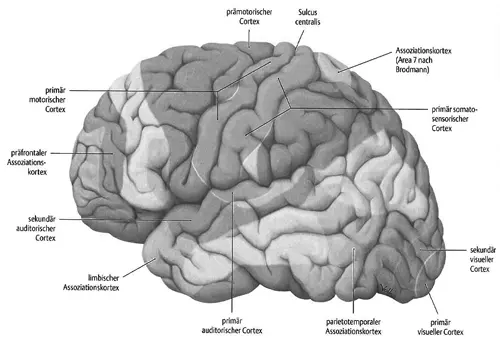

Um etwaige Verarbeitungsmechanismen besser zu verstehen und die verschiedenen Areale modalitätsspezifischer Verarbeitung zu lokalisieren, lohnt sich ein Blick in den Aufbau des menschlichen Gehirns: Demnach werden visuelle Reize im Okzipitallappen des Cortex (d.h. im hintersten Teil des Großhirns) verarbeitet, wohingegen empfangene auditive Signale in den Temporallappen (d.h. in den laterobasalen Teil des Großhirns) und taktile Informationen in den Parietallappen (auch: Schläfenlappen, d.h. in den mittleren/oberen Teil des Großhirns) geleitet werden.1

Visuelle Daten werden verarbeitet, indem das Auge optische Reize in Form von einfallenden Lichtstrahlen aufnimmt. Diese werden bei Eintreten in das Auge mehrfach gebrochen und erzeugen bei einem emmetropen (normalsichtigen) Auge eine verkleinerte und umgekehrte Projektion des betrachteten Objekts auf der Netzhaut ( Retina ). Dort werden die optischen Informationen durch die Photosensoren (Stäbchen und Zapfen für Dämmerungs- bzw. Farbsehen) in Nervenimpulse umgewandelt und über den Sehnerven ( Nervus opticus ) zum Gehirn weitergeleitet (cf. Silbernagl/Despopoulos 2012, 366sq.)

Die Verarbeitung auditiver Daten erfolgt hingegen durch die Aufnahme von Schallwellen über die Ohrmuschel in den Gehörgang, wo diese über das Trommelfell und im Mittelohr über die drei Gehörknöchelchen (Hammer, Amboss, Steigbügel) an die im Innenohr gelegene Cochlea (Ohrschnecke) weitergeleitet werden. Dies führt zu einer Aktivierung der dortigen Hörsinneszellen und Entstehung von Nervenimpulsen, die über den Hörnerven ( Nervus vestibulocochlearis ) zum auditiven Cortex gelangen (cf. ibid. 387sqq.).

Die sensorischen Module treffen in einem übergeordneten zentralen amodalen System zusammen, das die wesentlichen verbalen und nonverbalen Informationen mit bereits vorhandenen Konzepten abgleicht und weiterverarbeitet bzw. neue Konzepte aktiviert und in Form nichtsprachlicher Schemata organisiert (cf. Ballstaedt 1988, 10). Dieses befindet sich vermutlich in dem Bereich zwischen dem visuellen, dem auditiven und dem taktilen Verarbeitungsmodul (cf. Abb. 4).

Abb. 4: Areale modalitätsspezifischer Verarbeitung im menschlichen Gehirn (Schünke/Schulte/Schumacher 2006, 378)

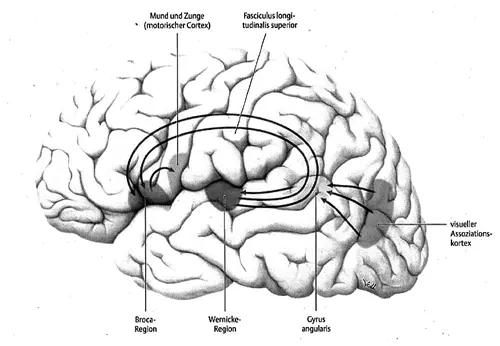

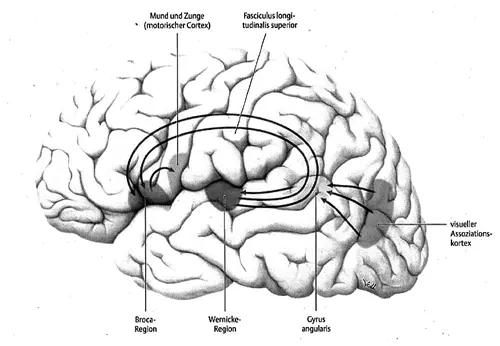

Neuroanatomischen Erkenntnissen zufolge geht man weiter davon aus, dass der Gyrus angularis „die Eingänge vom visuellen, akustischen und somatosensorischen Cortex [koordiniert] und […] die Wernicke-Region [beeinflusst]“ (Schünke/Schulte/Schumacher 2006, 381). Die Wernicke-Region ist für das Sprachverständnis zuständig und steht in direkter Verbindung zur Broca-Region, die für die Sprachproduktion verantwortlich ist. Beide Sprachzentren befinden sich normalerweise in der linken Hemisphäre des Gehirns und „sind durch den Fasciculus longitudinalis superior (=arcuatus) [sic] miteinander verbunden“ (ibid.) (cf. Abb. 5). Im Hinblick auf die Sprachverarbeitung geben aktuelle Studien zudem Hinweise darauf, dass sich die neuronale Aktivierung bei der Erst- (L1) und Zweitsprache (L2) teilweise voneinander unterscheidet. Dies gilt nach dem heutigen Kenntnisstand zwar nur für gewisse Teilfunktionen, könnte für die Schulung des fremdsprachlichen Hör-Seh-Verstehens aber dennoch von Bedeutung sein (cf. Mueller/Rüschemeyer/Friederici 2006, 182).

Abb. 5: Sprachregionen der normalerweise dominant linken Hemisphäre des menschlichen Gehirns (Schünke/Schulte/Schumacher 2006, 381)

Obgleich die neuronale Verarbeitung audiovisueller Stimuli – auch im Hinblick auf das fremdsprachliche Hör-Seh-Verstehen – weiterer Forschung bedarf, haben sich innerhalb der Fachdiskussion verschiedene Theorien der audiovisuellen Informationsverarbeitung herausgebildet, deren Modelle im Folgenden kurz skizziert werden. Eine ausführliche und detaillierte Gegenüberstellung kann an dieser Stelle nicht geleistet werden. Bei den Grundmodellen handelt es sich um ein dualistisches, ein monistisches sowie ein alternatives Modell der audiovisuellen Informationsverarbeitung. Allen Ansätzen ist gemein, dass sie von einem 3-Stufen-System ausgehen. Die erste Stufe beschreibt periphere Prozesse und Repräsentationen, bei der die Informationen modalitätsspezifisch aufgenommen und getrennt voneinander verarbeitet werden. Unterschiede bestehen zwischen den Modellen erst ab Stufe zwei, der Phase der repräsentationalen Informationsverarbeitung. Während Vertreter der dualistischen Theorie (e.g. Paivio) annehmen, dass eine Interaktion der Kanäle erst bei der referenziellen Informationsverarbeitung in Stufe drei stattfindet, gehen Vertreter des monistischen Modells von der Speicherung beider Sinnesmodalitäten in nur einem System aus (auch: amodales System).

Читать дальше