Так что же переносят сигналы?

Надеюсь, что читатель сам сможет ответить на этот вопрос. Любой сигнал, будь то свет костра, телеграмма, код Морзе написанный текст и т. д., несет какое-либо сведение, или сообщение! Одним словом — информацию. Таким образом, сигнал есть средство передачи информации.

Любой переданный сигнал переносится либо энергией, либо веществом. Иначе и быть не может, ведь наш мир материален. Это либо акустическая волна (звук), либо электромагнитное излучение (свет, радиоволна), либо лист бумаги (написанный текст), либо каменная скрижаль с выбитыми на ней магическими знаками. Но ни переданная энергия, ни посланное вещество сами по себе никакого значения не имеют, они служат лишь носителями информации. По мере удаления от передатчика поток энергии становится все слабее и слабее. Это тоже не имеет значения до тех пор, пока превышение сигнала над шумом достаточно для приема информации. Когда Москва передает по радио последние известия, одну и ту же информацию получает и подмосковный радиослушатель в г. Долгопрудном и уральский радиослушатель из Нижнего Тагила. Но поток энергии радиоволн в Нижнем Тагиле в тысячи раз меньше, чем под Москвой. Истрепанная книжка, если в ней нет вырванных страниц, несет ровно столько же информации, сколько такай же новая.

Каменная скрижаль весом в три тонны несет столько же информации, сколько ее хороший фотоснимок в археологическом журнале. Следовательно, мощность сигнала, так же как и вес носителя, никак не могут служить оценкой количества информации, переносимой сигналом. Как же оценить это количество?

Во время второй мировой войны подобные вопросы не на шутку заинтересовали шифровальщика при одном из штабов американских войск в Европе К. Шеннона. Упорство в достижении поставленной цели часто приносит успех, и после войны К. Шеннон защитил докторскую диссертацию, став основоположником новой науки — теории информации. В 1948–1949 годах увидели свет его статьи «Математическая теория связи» и «Связь в присутствии шума».

Любое сообщение можно свести к передаче чисел. Пылкий влюбленный, находясь в разлуке с объектом своей любви, посылает телеграмму: «Любишь?». В ответ приходит не менее лаконичная телеграмма: «Да!». Сколько информации несет ответная телеграмма? Альтернатив здесь две — либо Да, либо Нет. Их можно обозначить символами двоичного кода 1 и 0. Таким образом, ответную телеграмму можно было бы закодировать единственным символом «1». Выбор одного нз двух сообщений («Да» или «Нет», «1» или «0») принимают за единицу информации. Она названа «бит» — сокращение от английских слов binary digit , что означает двоичная цифра. Таким образом, ответная телеграмма несла всего 1 бит информации. А вопрос ценности этой информации для получателя-это уже из иной области.

Однако только что данное определение единицы информации слишком упрощено. Если влюбленный уверен в положительном ответе, то ответ «Да» не даст ему почти никакой новой информации.

Информация измеряется в битах.

То же самое относится и к безнадежно влюбленному, уже привыкшему получать отказы. Ответ «Нет» также принесет ему очень мало информации. Но внезапный отказ уверенному влюбленному (неожиданное огорчение) или ответ «Да» безнадежно влюбленному (нечаянная радость) несут сравнительно много информации, настолько много, что радикально изменяется все дальнейшее поведение влюбленного, а может быть, и его судьба! Таким образом, количество информации зависит от вероятности получения данного ответа.

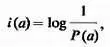

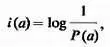

Лишь при равновероятных ответах ответ «Да» или «Нет» несет 1 бит информации. Общая формула для подсчета количества информации, содержащегося в сообщении а, выглядит гак

где Р( а ) — вероятность появления данного (дискретного) сообщения а .

Обратите внимание, что для абсолютно достоверного события P( а ) = 1 (событие обязательно произойдет, поэтому его вероятность равна единице), при этом количество информации в сообщении о таком событии i( а ) = 0. Чем невероятнее событие, тем большую информацию о нем несет сообщение.

Но зачем в приведенной формуле использована логарифмическая функция? Нельзя ли проще? Нет, проще не получается. Информация, содержащаяся в двух независимых сообщениях a 1 , и а 2 , должна быть равна сумме информации, содержащихся в каждом из сообщений: i( a 1,a 2 ) = i( a 1 ) + i( a 2 ). Логичное требование, не правда ли? Но вероятность того, что источник пошлет оба эти сообщения, одно за другим, равна произведению вероятностей появления каждого из сообщений: P( a 1,a 2 ) = Р( а 1 )· Р( а 2 ). Как известно, при умножении двух величин их логарифмы складываются. Поэтому и количество информации должно выражаться логарифмической функцией.

Читать дальше