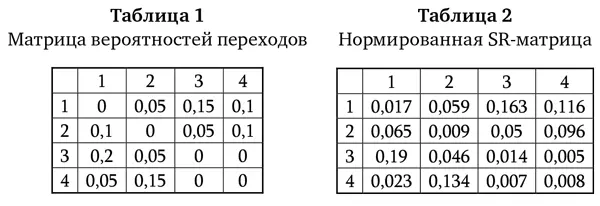

Оценка SR-матрицы, построенная по заданной последовательности посещенных областей интереса, содержит сумму взвешенных по удаленности во времени будущих попаданий в некоторую область интереса, определяемую заданным столбцом при условии, что в данный момент посещена область, определяемая строкой. Заметим, что получаемая матрица не является стохастической (т. е. ее элементы не представляют собой оценки вероятностей). Поэтому сумма всех значений столбца SR-матрицы может превышать единицу. Для корректного сопоставления SR-матриц, полученных для записей различной длительности, необходимо эти матрицы нормировать (делить каждый элемент на сумму элементов матрицы). Однако нормирование может и не проводиться, если исследователя интересует, в частности, вариация длительностей траекторий взора.

Стоит заметить, что относительно недавно была продемонстрирована формальная связь концепции представления преемника и модели эпизодической и семантической памяти (Howard, Kahana, 2002; Sederberg et al, 2008).

Важным отличием между матрицей представления преемника и матрицей вероятностей переходов является то, что последняя отражает закономерности только первого порядка (касающиеся переходов между смежными элементами последовательности), в то время как первая настраивается для предсказания будущих посещений в рамках временного окна, чья эффективная ширина зависит от коэффициента у (Gershman et al., 2012).

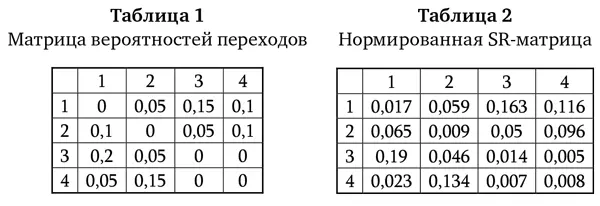

Пусть дана следующая последовательность номеров посещенных областей интереса: [ 1, 2, 4, 2, 4, 1, 4, 2, 3, 1, 3, 2, 1, 3, 1, 2, 4, 1, 3, 1, 3 ]. По заданной последовательности вычислены матрица вероятностей переходов и нормированная SR-матрица, представленные в таблицах 1 и 2.

Приведенный пример матриц демонстрирует, например, что оценка вероятности переходов из области № 4 в область № 3 является нулевой, поскольку прямых переходов из области № 4 в область № 3 в последовательности не наблюдается. При этом матрица представления преемника отражает взвешенное по временной удаленности нормированное количество будущих пребываний в области № 3 после пребывания в области № 4 (ячейка № 3.4), а также указывает, например, на то, что ближайшие по времени будущие попадания в область № 3 после пребывания в ней же более вероятны (ячейка № 3.3), нежели будущие попадания в область № 4.

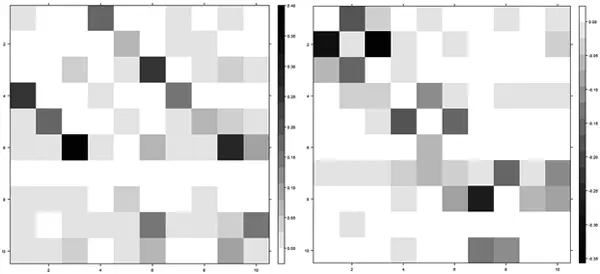

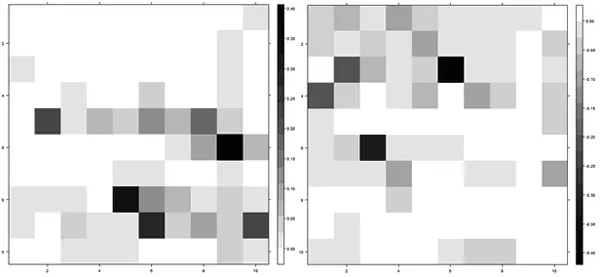

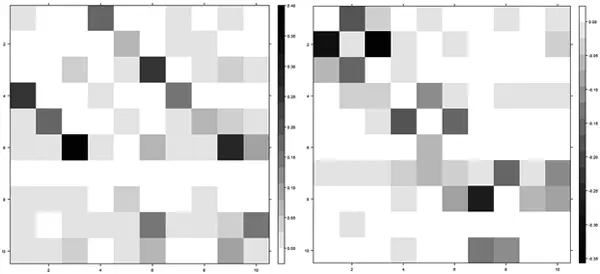

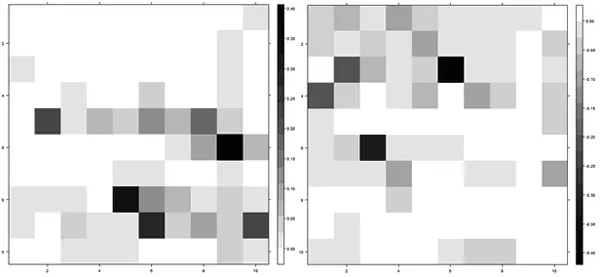

Сокращение размерности пространства переменных и анализ выделенных компонент или факторов. Рассчитав значения традиционных интегральных показателей и дополнительные информативные признаки, для сокращения размерности пространства анализируемых переменных можно с помощью соответствующего метода выделять скрытые главные компоненты или факторы, объясняющие высокую долю суммарной дисперсии полученного набора переменных. Важным аспектом при выборе компоненты/фактора является как доля описываемой дисперсии, так и возможность интерпретации новой переменной по величинам компонентных нагрузок наблюдаемых переменных (частных корреляций переменных и компонент). Примеры двух главных компонент, описывающих 19,5 % доли суммарной дисперсии элементов SR-матриц, построенных по последовательностям фиксаций взора в областях интереса, выделенных на стимульном материале теста Равена, приведены на рисунках 3 и 4. Номера столбцов и строк данных матриц совпадают с номерами областей интереса, выделенных в стимульном материале заданий теста Равена (1, 2, 3 – верхняя строка элементов матрицы задания; 4, 5, 6 – средняя строка; 7, 8, 9 – нижняя строка; 10 – область альтернатив ответа).

Рис. 3.Цветовые матрицы, отражающие величину нагрузок первой главной компоненты, описывающей 12,5 % суммарной дисперсии элементов SR-матриц: слева приведена матрица для положительных нагрузок (диапазон значений нагрузок – от 0 до 0,4), а справа – для отрицательных (диапазон – от -0,4 до 0)

Рис. 4.Цветовые матрицы, отражающие величину нагрузок второй главной компоненты, описывающей 7 % суммарной дисперсии элементов SR-матриц: слева приведена матрица для положительных нагрузок (диапазон значений нагрузок – от 0 до 0,4), а справа – для отрицательных (диапазон – от -0,4 до 0)

Читать дальше

Конец ознакомительного отрывка

Купить книгу