6) в математике, кибернетике — количественная мера устранения энтропии (неопределенности), мера организации системы;

7) в философии — свойство материальных объектов и процессов сохранять и порождать определенное состояние, которое в различных вещественно-энергетических формах может быть передано от одного объекта другому; степень, мера организованности какого-либо объекта (системы).

Вместе с тем физические аспекты информации не переставали привлекать внимания исследователей. Одним из важных следствий этого является тот вывод, что при физическом подходе нет надобности вводить новую меру количества информации. Вряд ли существуют природные явления или отрасли техники, в которых физические процессы переноса и преобразования информации не играли бы выдающейся роли. Более того, невозможно отличить — не только теоретически, но и практически — энергетическое или силовое воздействие от последствий получения информации, заключенном в этом воздействии. Проблемы причинности и физической сущности пространства и времени тесно связаны с категорией информации, которая (независимо от терминологии) используется естествоиспытателями с незапамятных времен.

Тем не менее нельзя не отметить определенного эклектизма в обращении с этой категорией не только в различных областях науки, но и в практике, что породило впечатление о «нефизичности», «неосязаемости» информации, вплоть до независимости существования и переноса информации от существования и переноса энергии; энергетические затраты в таких воззрениях связываются только с преодолением помех.

Чтобы в такой ситуации взяться за популяризацию проблемы энтропии, требуется, конечно, немалое мужество. Вот почему заслуживает всяческой поддержки замысел автора показать место и значение проблемы в современной науке и особенно в естествознании.

Энтропию автор трактует скорее как гносеологическую, чем физическую категорию, что позволяет ему ненавязчиво и убедительно раскрыть ее сущность и определить сферу применимости.

Мне кажется, что автору вполне удалась попытка о сложном рассказать просто и занимательно. Благодаря эмоциональному изложению сложные представления воспринимаются без особого напряжения. Автор несомненно владеет пером популяризатора, и книга его читается с интересом. Но основное достоинство книги я вижу в том, что она заставляет думать, а иногда и спорить. Ведь популярная литература, по-моему, и призвана прежде всего привлекать и приучать к размышлению, развивать пытливость и пробуждать любознательность.

Д. С. Конторов,

доктор технических наук профессор

Исходя из этого свойства энтропии, известный американский физик Дж. Гиббс называл энтропию «размешанностью» ( mixedupness ).

Сноу Ч. П.— известный современный английский писатель, ученый и публицист, автор одиннадцатитомной эпопеи «Чужие и братья». Приводимые ниже высказывания заимствованы из книги Сноу «Две культуры» (Прогресс, 1973), по поводу которой во всем мире разгорелся спор «физиков» и «лириков» о соотношении пользы и ценности искусства и точных наук.

Создавая вероятностную теорию энтропии, Больцман рассматривал не только реальное пространство, но и условное «пространство скоростей». Он показал, что скорости молекул (так же как и сами молекулы) стремятся равномерно «заполнить предоставленное им пространство». Когда газ достигает состояния равновесия, распределение вероятностей скоростей подчиняется нормальному закону, описываемому формулой и кривой Максвелла.

Этим научным проблемам посвящена, в частности, написанная автором книга: «Эволюция и информация». М., Наука, 1976.

Одна из 32 карточек должна быть пустой. При извлечении этой карточки в тексте оставляется пропуск, соответствующий интервалу между словами.

Сравните с вероятностью появления тех же букв в описанном

эксперименте: Р о= Р ф= 1/ 32= 0,03

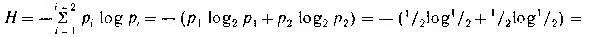

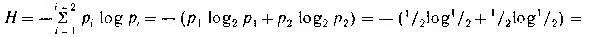

Все значения энтропии и информации в битах подсчитываются с помощью функции

Пример I. Энтропия сообщений типа «У А. родилась дочка», «В. играет белыми» равна:

1 бит

1 бит

Пример II. Энтропия появления каждой следующей буквы в тексте равна:

Читать дальше

1 бит

1 бит